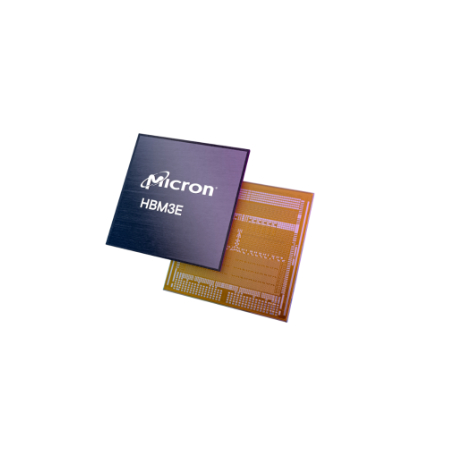

美光宣布量产HBM3E,号称比竞品功耗降低约30%

编辑:AVA 发布:2024-02-27 10:20美光宣布已开始批量生产 HBM3E解决方案。美光24GB 8H HBM3E 将成为NVIDIA H200 Tensor Core GPU的一部分,该 GPU 将于 2024 年第二季度开始发货。

随着人工智能需求持续激增,对内存解决方案的需求至关重要,以跟上不断扩大的工作负载的步伐。美光的 HBM3E 解决方案通过以下方式正面应对这一挑战:

卓越性能:美光 HBM3E 的引脚速度超过9.2 Gb/s,可提供超过1.2 TB/s的内存带宽,为 AI 加速器、超级计算机和数据提供闪电般的数据访问中心。

卓越的效率:美光科技的 HBM3E 领先业界,与竞争产品相比,功耗降低约 30% 。 为了支持不断增长的人工智能需求和使用,HBM3E 以最低的功耗提供最大的吞吐量,以改善重要的数据中心运营支出指标。

无缝可扩展性:美光 HBM3E 目前拥有24 GB 容量,允许数据中心无缝扩展其人工智能应用程序。无论是训练大规模神经网络还是加速推理任务,美光的解决方案都提供了必要的内存带宽。

美光科技利用其 1-beta 技术、先进的硅通孔 (TSV) 以及其他可实现差异化封装解决方案的创新技术,开发了这一业界领先的 HBM3E 设计。美光是 2.5D/3D 堆叠内存和先进封装技术领域久经考验的领导者,并成为台积电 3DFabric 联盟的合作伙伴,帮助塑造半导体和系统创新的未来。

美光还通过 36GB 12-High HBM3E 样品扩大了其领先地位,与竞争解决方案相比,该产品预计将提供超过 1.2 TB/s 的性能和卓越的能效。美光将在英伟达3月 18 日召开的全球人工智能大会上分享更多有关人工智能内存产品组合和路线图的信息。

.jpg)