美光基于1β 24Gb芯片的24GB HBM3已开始送样

编辑:AVA 发布:2023-07-27 11:21美光科技宣布,已开始送样其首款8-high 24GB HBM3 Gen2内存产品,带宽大于1.2TB/s,引脚速度超过9.2Gb/s,比目前推出的HBM3解决方案提高50%。其每瓦性能比前几代产品提高了2.5 倍,为人工智能 (AI) 数据中心关键指标的性能、容量和能效创造了新记录。美光的这些改进减少了GPT-4 等大型语言模型及其他模型的训练时间,为 AI 推理提供高效的基础设施使用,并提供卓越的总拥有成本 (TCO)。

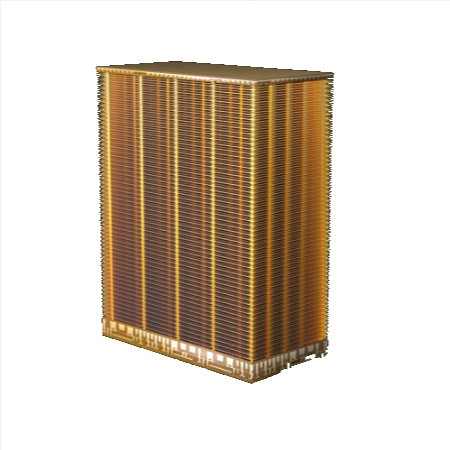

美光HBM解决方案采用1β (1-beta) DRAM工艺节点,该节点允许将 24Gb DRAM 芯片组装到行业标准封装尺寸内的8-high立方体中。此外,美光的 12 高堆栈(容量为 36GB)将于 2024 年第一季度开始提供样品。与现有的竞争解决方案相比,美光在给定堆栈高度下提供的容量增加了 50%。

美光的 HBM3 Gen2 性能功耗比和引脚速度改进对于管理当今人工智能数据中心的极端功耗需求至关重要。美光硅通孔 (TSV) 比竞争对手的 HBM3 产品增加一倍,通过金属密度增加五倍来降低热阻。

作为 HBM3 Gen2 产品开发工作的一部分,美光与台积电之间的合作为 AI 和 HPC 设计应用的计算系统的顺利引入和集成奠定了基础。台积电已收到美光 HBM3 Gen2 内存样品,并正在与美光密切合作进行进一步评估和测试,这将有利于客户下一代 HPC 应用的创新。

美光 HBM3 Gen2 解决方案满足了生成式 AI 领域对多模式、数万亿参数 AI 模型日益增长的需求。每个立方体容量为 24GB,引脚速度超过 9.2Gb/s,大型语言模型的训练时间减少 30% 以上,从而降低 TCO。此外,美光的产品使每天的查询量显著增加,从而能够更有效地使用经过训练的模型。美光 HBM3 Gen2 内存一流的每瓦性能为现代人工智能数据中心带来了切实的成本节约。对于安装 1000 万个 GPU 的情况,每个 HBM 立方体可节能 5 瓦,预计在五年内可节省高达 5.5 亿美元的运营费用。

据官方介绍,美光HBM3 Gen2在美国进行设计和工艺开发,在日本进行内存制造,在台湾地区进行先进封装。

美光此前宣布推出基于1α (1-alpha) 24Gb 单片 DRAM 芯片的 96GB DDR5 模块,用于容量需求大的服务器解决方案,今天则推出了基于 1β 24Gb 芯片的 24GB HBM3 产品。美光计划在 2024 年上半年推出基于1β 32Gb 单片 DRAM 芯片的 128GB DDR5 模块。